在本章中,我們將瞭解可以使用TensorFlow框架實現的神經網路訓練的各個方面。

以下幾個建議,可以評估 -

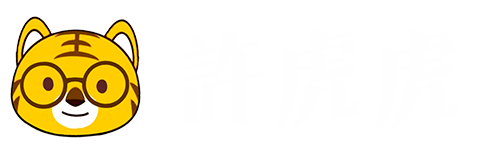

1. 反向傳播

反向傳播是計算偏導數的簡單方法,其中包括最適合神經網路的基本形式的合成。

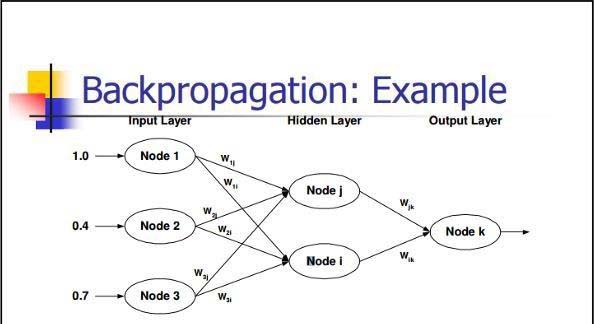

2. 隨機梯度下降

在隨機梯度下降中,批處理是示例的總數,用戶用於在單次迭代中計算梯度。到目前為止,假設批處理已經是整個數據集。最好的例子是穀歌規模; 數據集通常包含數十億甚至數千億個示例。

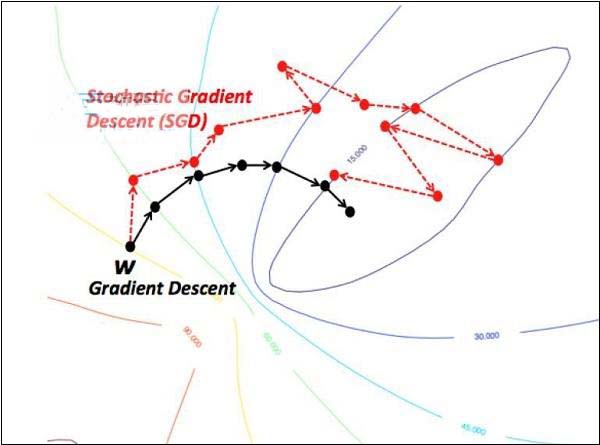

3. 學習率衰減

調整學習速率是梯度下降優化的最重要特徵之一。這對TensorFlow實施至關重要。

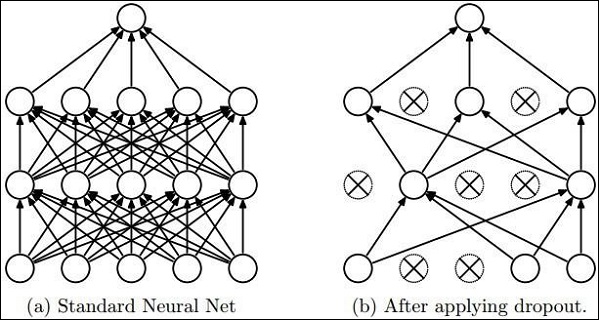

4. Dropout

具有大量參數的深度神經網路構成了強大的機器學習系統。然而,過度擬合是這種網路中的嚴重問題。

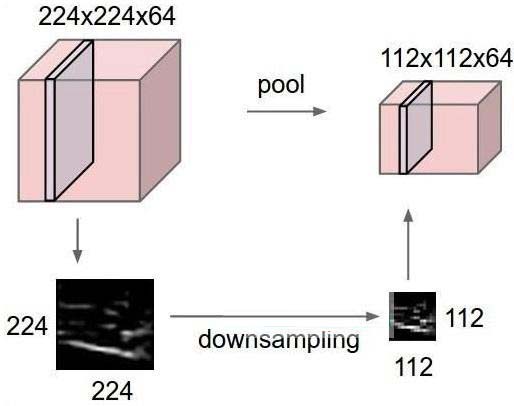

5. 最大池

最大池化是基於樣本的離散化過程。目標是對輸入表示進行下採樣,從而減少具有所需假設的維數。

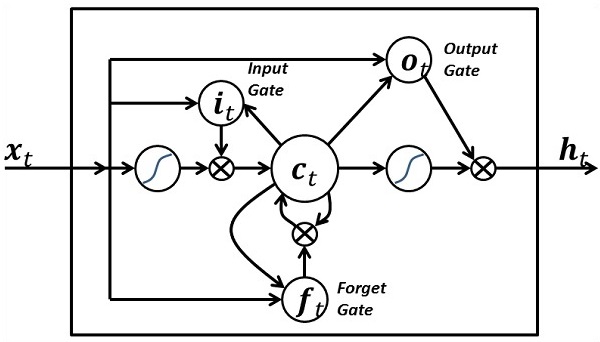

6.長期短期記憶(LSTM)

LSTM控制在指定神經元內應該採取什麼輸入的決定。它包括控制決定應該計算什麼以及應該生成什麼輸出。

上一篇:

TensorFlow識別圖像

下一篇:無