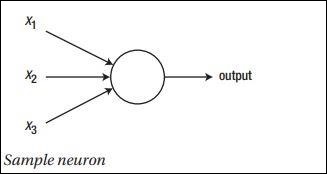

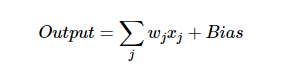

神經網路的主要原理包括一系列基本元素,即人工神經元或感知器。它包括幾個基本輸入,如:x1,x2 …… .. xn,如果總和大於啟動潛在量,則產生二進位輸出。

樣本神經元的示意圖如下所述 -

產生的輸出可以認為是具有啟動潛在量或偏差加權和。

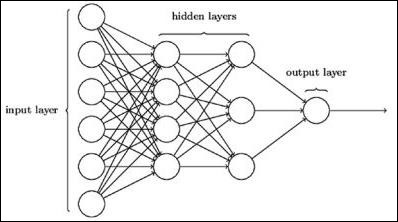

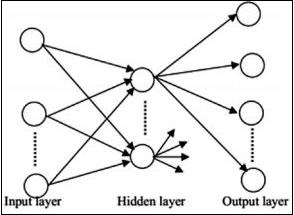

典型的神經網路架構如下所述 -

輸入和輸出之間的層稱為隱藏層,層之間的連接密度和類型是配置。例如,完全連接的配置使層L的所有神經元連接到L + 1的神經元。對於更明顯的定位,我們只能將一個局部鄰域(比如九個神經元)連接到下一層。上圖中顯示了兩個具有密集連接的隱藏層。

神經網路的類型如下 -

前饋神經網路

前饋神經網路包括神經網路族的基本單元。這種類型的神經網路中的數據移動是通過當前隱藏層從輸入層到輸出層。一層的輸出用作輸入層,對網路架構中的任何類型的環路都有限制。

遞歸神經網路

遞歸神經網路是指數據模式在一段時間內發生變化的時間。在RNN中,應用相同的層來接受輸入參數並在指定的神經網路中顯示輸出參數。

可以使用torch.nn包構建神經網路。

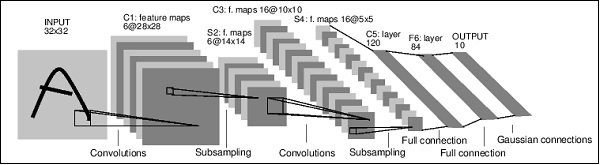

它是一個簡單的前饋網路。它接受輸入,一個接一個地通過幾個層輸入,然後最終給出輸出。可以使用以下步驟進行神經網路的典型訓練過程 -

- 定義具有一些可學習參數(或權重)的神經網路。

- 迭代輸入數據集。

- 通過網路處理輸入。

- 計算損失(輸出距離正確多遠)。

- 將漸變傳播回網路參數。

- 通常使用下麵給出的簡單更新來更新網路的權重。

規則: weight = weight -learning_rate * gradient

上一篇:

神經網路數學構建模組

下一篇:

機器學習與深度學習